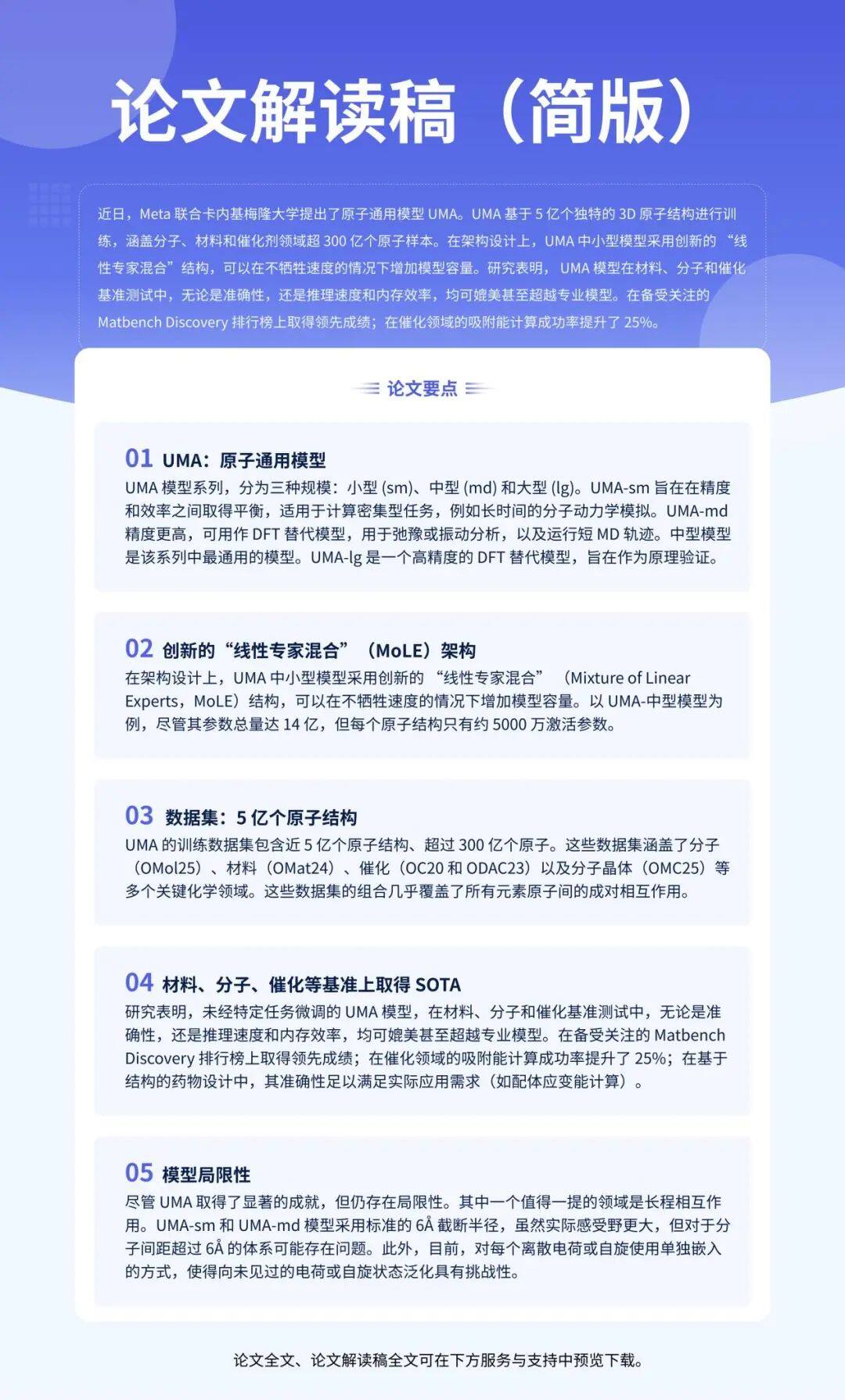

近日,Meta 联合卡内基梅隆大学提出了原子通用模型 UMA。UMA 基于 5 亿个独特的 3D 原子结构进行训练,涵盖分子、材料和催化剂领域超 300 亿个原子样本。

研究开发的经验缩放定律,旨在助力研究人员理解在扩大数据集规模的过程中,如何同步提升模型容量,进而实现最佳的准确性。

在架构设计上,UMA 中小型模型采用创新的 “线性专家混合” (Mixture of Linear Experts,MoLE)结构,可以在不牺牲速度的情况下增加模型容量。以 UMA-中型模型为例,尽管其参数总量达 14 亿,但每个原子结构只有约 5000 万激活参数。

研究人员在多个领域、不同任务集上对 UMA 模型展开评估,研究表明,未经特定任务微调的 UMA 模型,在材料、分子和催化基准测试中,无论是准确性,还是推理速度和内存效率,均可媲美甚至超越专业模型。

在备受关注的 Matbench Discovery 排行榜上取得领先成绩;在催化领域的吸附能计算成功率提升了 25%;在基于结构的药物设计中,其准确性足以满足实际应用需求(如配体应变能计算)。

论文原文及解读稿全文已上线超算互联网「论文研读」店铺,可点击文末“阅读原文”获取。

投递邮箱:scnet_contest@163.com

也可扫描下方二维码添加超算互联网小编企业微信进行投稿。还可入群交流,共同探讨 AI4S 发展,快速把握科研领域的热点资讯。

相关新闻

-

2025-07-18

软硬协同 性能突围 | 在超算互联网体验全新ABACUS LTS v3.10

-

2025-07-18

最佳实践Vol.48 | LAMMPS计算速度自相关函数(VACF)与声子态密度(PDOS)分析详解

-

2025-07-18

深耕AI应用!超算互联网《国产大模型应用生态图谱》正式发布

-

2025-07-18

国家高性能计算机工程技术研究中心加入“天津市人工智能创新生态联盟”

-

2025-07-18

报名 | 中国科学院计算机网络中心开展超算互联网培训

津公网安备12011602300273号

津公网安备12011602300273号

电子营业执照

电子营业执照

微信服务号

微信服务号