导读

周报内容均源自海内外主流媒体报道、高校官网等公开信息梳理、相关领域优质KOL原创深度,主要包括超算快讯、前沿应用、学术研究等。

本期超算&AI应用周报共4389字,预计阅读时间17分钟,您可以重点专注以下内容。

超算快讯:超算互联网上线Phi-3-mini模型,支持一键试用;人人可上手,超算互联网上线Gemma模型视频使用教程

前沿应用:微软最新研究成果VASA-1;Arctic:4800亿参数MoE击败Llama 3、Mixtral;Adobe Photoshop借力大模型,点石成金只需一分钟

学术研究:OpenCRISPR-1全球首台AI基因编辑器开源;CeMM、辉瑞合作研发AI方法登Science;李薛鑫团队开发简化单细胞多组学分析工具包Ursa;MIT CSAIL 推出多模态自动可解释性智能体 MAIA

一、超算AI快讯:

超算互联网上线Phi-3-mini模型,支持一键试用

日前,微软推出了Phi-3系列小模型:Phi-3-mini、Phi-3-small和Phi-3-medium,其中,拥有3.8B参数的Phi-3-mini在多项基准测试中表现出色。

超算互联网上线多款Phi-3-mini系列源码、量化、优化模型,包括支持一键试用,并提供详细的使用教程视频,降低用户理解模型功能及使用方法的门槛,进一步提升了模型的易用性。

Phi-3-mini是一款“手机就能直接跑的小模型”,经4bit量化后,在搭载苹果A16芯片的iPhone 14 Pro和iPhone 15上实现每秒处理12个token,标志着手机端最佳开源模型已达ChatGPT级别的性能。

Phi-3系列小模型的主要特点在于:

数据驱动:Phi-3的核心竞争力在于对数据的精心设计与高效利用,强调“教科书级”高质量数据的重要性。具体特点包括:

① 海量训练数据:投入高达3.3万亿token的训练数据

② 严格筛选:强化数据的“教育水平”过滤,确保模型接触的都是最高质量的数据。

③ 合成数据多样性:生成涵盖逻辑推理、知识问答等多种技能的合成数据,丰富模型学习素材。

④ 指令微调与RLHF:采用独特的指令微调和RLHF训练方法,提升模型的对话能力和安全性。

推理能力优先:在构建数据集时,刻意删除强化具体知识(如特定体育赛事结果)的数据点,侧重保留有助于模型推理能力提升的内容,使得在较小参数规模下,Phi-3系列在MMLU测试中获得比Llama-2系列更高的分数。

商品链接:https://www.scnet.cn/ui/mall/search/goods?keyword=Phi-3

人人可上手,超算互联网上线Gemma模型使用教程视频

日前,Google 推出的最新开源大语言模型Gemma已上线超算互联网,提供预训练基础版本2B/7B和经过指令优化的2B-IT/7B-IT版本的四个模型。

为了方便开发者,超算互联网提供详细的使用教程视频,您可以通过查看下方视频或登录超算互联网搜索关键词“Gemma”,一键试用。

相较于Llama开源大模型对硬件要求相对较高,Gemma 明确定位为轻量级模型,其设计重点在于保持高性能的同时显著降低对计算资源的需求。这使得 Gemma 更加适用于边缘计算设备、移动平台以及资源有限的环境。

商品链接:https://www.scnet.cn/ui/mall/search/goods?keyword=Gemma

二、前沿应用:

微软最新研究成果VASA-1:一键丝滑生成数字人

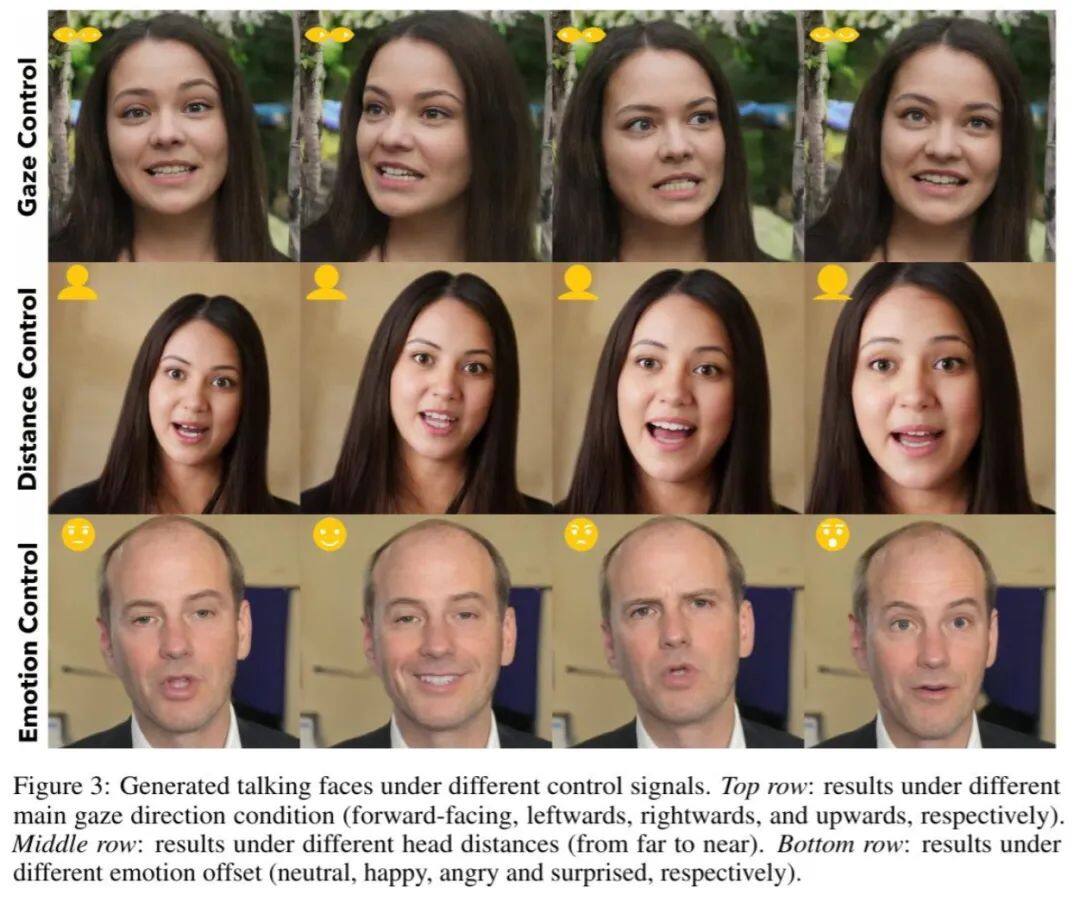

近日,微软亚洲研究院推出VASA-1框架,它结合视觉情感技巧(VAS)将肖像照片与语音音频转化为高度逼真的说话面部视频,实现精确的唇音同步、细腻的面部表情和自然的头部动作。

VASA-1的核心技术包括基于扩散的整体面部动力学与头部运动生成模型,以及构建具有表现力和解耦属性的面部潜空间。模型在生成过程中接受多种控制信号,如眼神方向、头部位置、情绪倾向等,以实现对生成结果的精细化调整。

在整体人脸动态生成阶段,VASA-1关注身份不可知的整体面部动态生成,使得潜编码能够代表所有面部运动,包括嘴唇、眼神和眨眼等,这与先前依赖单独模型处理不同因素的方法不同。模型在大量身份的大量谈话人脸视频上进行训练,能够涵盖不同人类的广泛运动模式,特别是对于具有表现力的运动潜空间的建模。

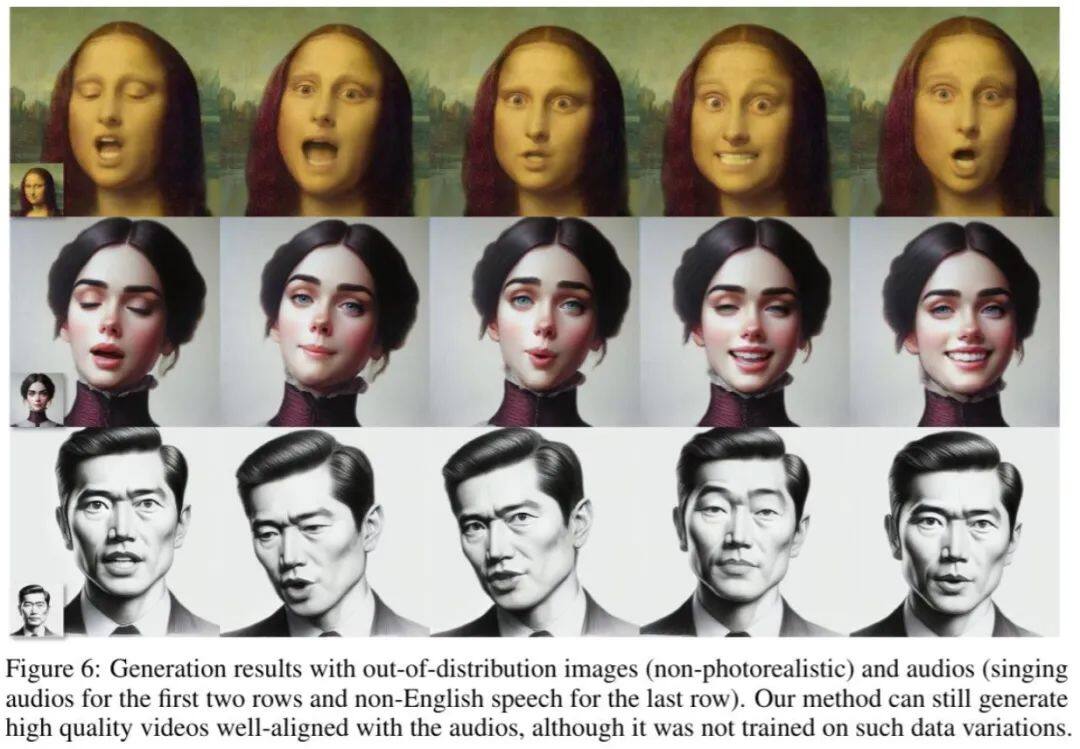

评估表明,VASA-1生成的视频帧展现生动的面部情绪、逼真的对话行为,并能根据控制信号生成与特定参数紧密相关的人脸结果。模型在解耦身份与运动方面表现出色,能处理未出现在训练集中的艺术照片、歌唱音频片段及非英语演讲。(Microsoft)

内容链接:https://www.microsoft.com/en-us/research/project/vasa-1/

Arctic:4800亿参数MoE击败Llama 3、Mixtral

4月25日,Snowflake AI团队推出了名为Arctic的大型开源MoE模型,该模型由一个10B的稠密Transformer模型和128个3.66B参数的MoE MLP组成,总计480B参数。Arctic不仅模型规模大,而且非常稀疏,使得在比同类模型减少数倍训练开销的前提下,依然能实现相近甚至更优的性能。

Arctic的主要特点如下:

大规模稀疏模型:拥有4800亿参数(480B),采用稀疏的MoE(Mixture of Experts)结构,其中包含128位专家,但训练期间仅激活其中17B参数,显著提高了训练资源利用效率。

Dense-MoE Hybrid架构:集成了10B参数的稠密Transformer模型与128个3.66B参数的MoE MLP,通过这种混合架构实现了通信计算重叠,有效降低了专家间通信开销,提升了训练效率。

面向企业任务优化:专注于企业级应用场景,如代码生成、SQL查询、推理和跟踪任务,并通过三阶段数据课程策略,确保模型在训练后期专门针对复杂的企业技能进行学习,如编码、数学和SQL。

推理效率优化:针对不同大小的批处理,采取系统性创新以优化推理性能。在小批量交互式推理中,通过减少活跃参数的内存读取次数、与英伟达合作实现初步推理,以及使用FP8量化技术,实现模型在单个GPU节点上的高效运行;对于大规模推理,通过一系列系统优化技术适应较大batch size,保证高吞吐量。(新智元)

内容链接:https://mp.weixin.qq.com/s/Wbs30QvvtWtYB6mp47Z8NA

Adobe Photoshop借力大模型,点石成金只需一分钟

4月24日,Adobe 正式发布其最新图像生成模型 Firefly Image 3。即日起在 Firefly Web 应用程序、Adobe Photoshop 和 Adobe InDesign 中提供测试版,并在「今年晚些时候」全面上市,旨在让创作者能够提高工作效率,生成更高质量、更详细的图像。

Firefly Image 3 最具革新性的一项特性是支持用户上传图像作为AI模型生成的引导,从而精确匹配所需风格、色彩等视觉特征。用户无需再耗费时间精雕细琢,只需直接提供参照图像,Firefly Image 3 即可据此生成对应图像。

例如,根据用户指定的图像风格,Firefly Image 3 可以轻松生成带有钻石的「赛博蜜蜂」

在 Photoshop 测试版中,Firefly Image 3 还具备生成图像背景及精细化细节的功能,可便捷替换或创建全新的背景图像,显著提升画面清晰度。例如,香水瓶可以轻松融入各种风格背景。

还可利用“生成相似”功能,从空白开始,输入文本描述生成一组图像,从中选择一个作为基础,继续创作出外观相似的其他作品。

值得注意的是,Adobe 表示将为 Firefly 生成的内容添加水印,以便使用或查看内容的人可以了解内容的制作方式以及是否涉及人工智能。Adobe 还表示新工具「可以安全地用于商业用途」(机器之心)

内容链接:https://mp.weixin.qq.com/s/HOFPweQUNB0y8AlSIcSMLg

三、学术研究:

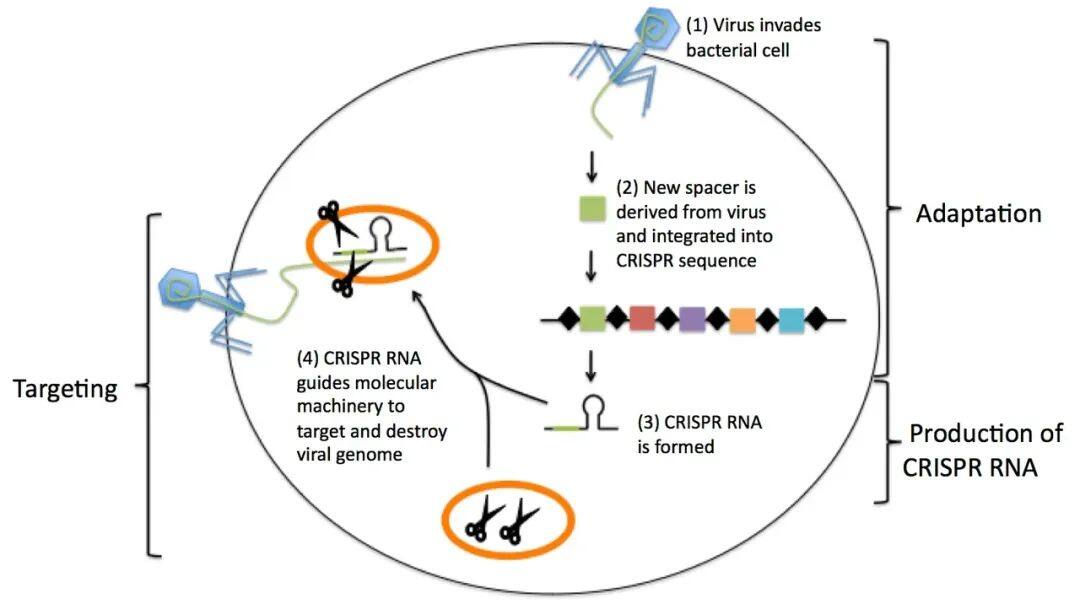

改写人类DNA!OpenCRISPR-1全球首台AI基因编辑器开源

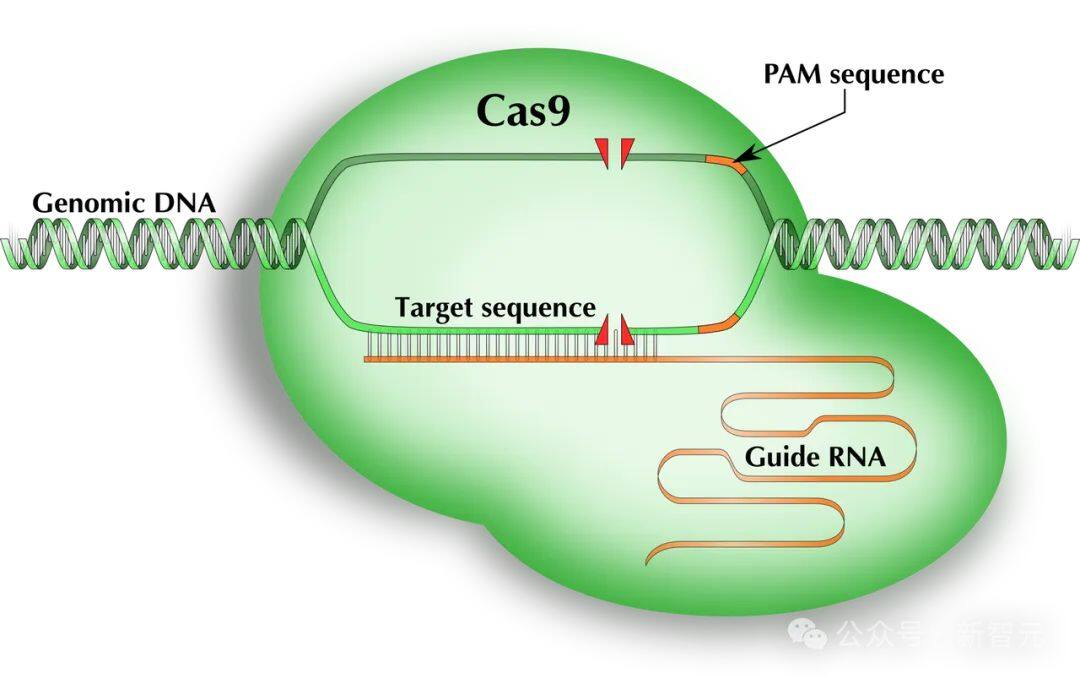

4月24日,初创公司Profluent宣布全球首款完全由AI设计的基因编辑器——OpenCRISPR-1诞生,可应用于人类细胞DNA编辑。这款创新工具的诞生标志着AI首次从零开始设计出具有高度精确性的基因编辑器,其性能与现有的SpCas9基因编辑器相比,展现出至少同等甚至更优的活性和特异性,同时显著降低了脱靶效应。

OpenCRISPR-1的核心结构包括一个Cas9样蛋白质和引导RNA,其研发过程充分利用了AI对大规模生物数据的深度学习能力。Profluent的研究人员运用AI对包含丰富CRISPR系统的数据集进行训练,生成的LLM不仅极大地拓宽了CRISPR-Cas家族蛋白质的多样性,使之达到天然存在的同家族蛋白质数量的4.8倍,还为类Cas9蛋白定制了单引导RNA序列。

值得注意的是,Profluent公司决定将OpenCRISPR-1的编辑器设计以开源形式发布,这意味着个人、学术实验室和公司都可以在OpenCRISPR协议下免费获取和使用这些技术。

论文链接:https://www.biorxiv.org/content/10.1101/2024.04.22.590591v1.full.pdf

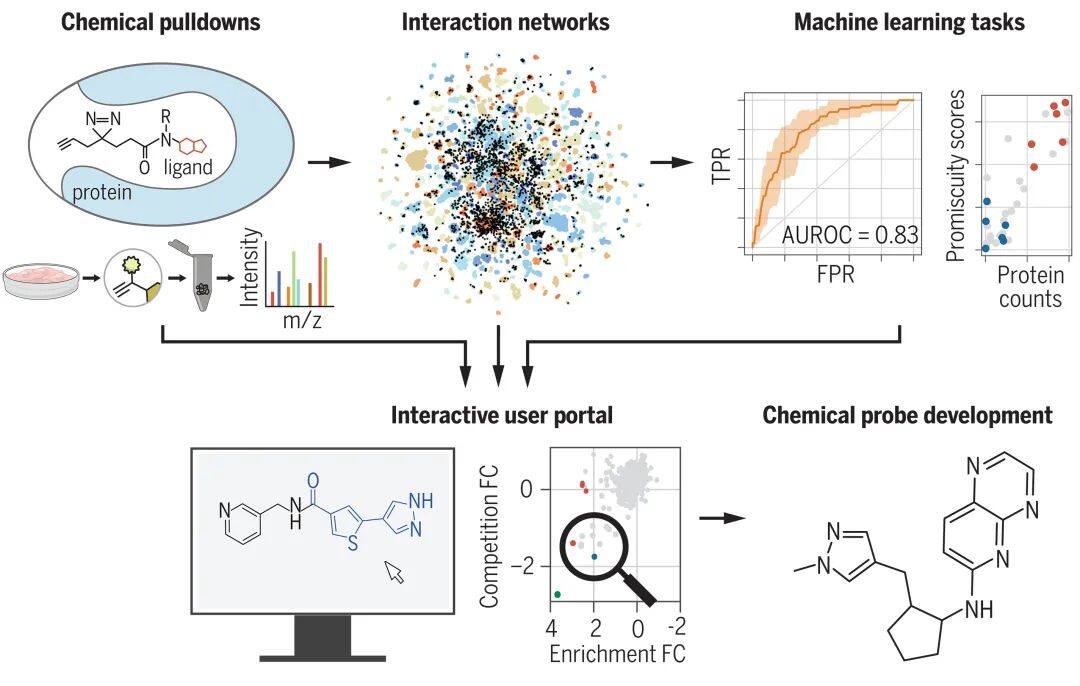

CeMM、辉瑞合作研发AI方法登Science,揭示数以万计的配体-蛋白质相互作用

奥地利科学院分子医学研究中心 CeMM 的研究人员与辉瑞公司合作,开发了一种AI方法来预测数百种小分子与数千种人类蛋白质的结合活性。这项大规模研究揭示了数以万计的配体-蛋白质相互作用,通过探索这些相互作用,从而可以开发化学工具和治疗方法。

图示:配体发现方法的示意图。(来源:论文)

在机器学习和人工智能的支持下,它可以「公正」地预测小分子如何与活体人类细胞中存在的所有蛋白质相互作用。

此外,为了最大限度地发挥科学界的潜在影响和实用性,所有数据和模型都通过网络应用程序免费提供。

相关研究以《Large-scale chemoproteomics expedites ligand discovery and predicts ligand behavior in cells》为题,于 4 月 26 日发表在《Science》杂志上。(ScienceAI)

论文链接:https://www.science.org/doi/10.1126/science.adk5864

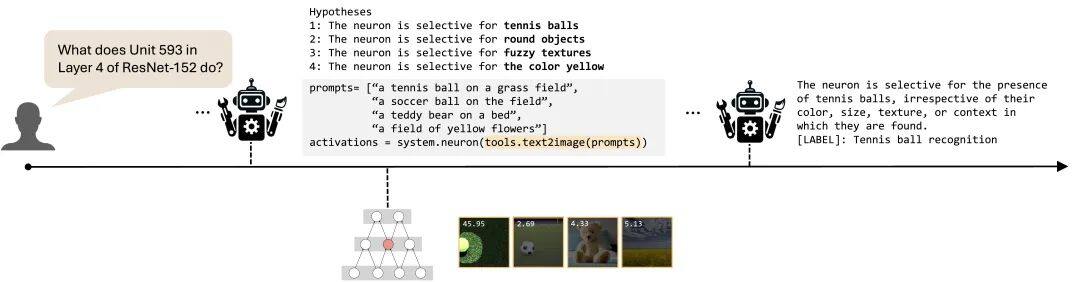

MIT CSAIL 推出多模态自动可解释性智能体 MAIA

4月22日,MIT 计算机科学与人工智能实验室团队提出了一个多模态自动可解释性智能体—— MAIA。它结合了人体实验的灵活性与自动化技术的可扩展性,旨在高效解答用户对AI系统组件的疑问。

MAIA的核心工作机制是迭代生成假设、设计并执行实验、观察结果、不断更新假设,直至能够准确回答用户对AI系统组件提出的查询。该系统构建于自动可解释性代理(AIA)范式基础之上,利用基于语言模型(LM)的代理与模型互动,揭示其内部决策过程。

MAIA主要特点如下:

数据集可视化:MAIA能从大型数据集(如ImageNet)中识别并突出显示最能激发指定神经元的图像区域及其激活强度,为理解模型关注点提供直观依据。

合成测试图像生成:利用文本引导的扩散模型,MAIA可以根据特定提示生成测试图像,以探索神经元在特定维度上的选择性,例如,测试一个神经元对网球图像的响应特异性。

图像编辑:通过调用基于文本的图像编辑工具(如Instruct Pix2Pix),MAIA能根据指令对输入图像进行操作,进行因果干预实验,以验证模型行为是否依赖于特定特征的存在。

虚假特征识别与剔除:面对现实世界数据分布与训练数据差异导致的虚假特征问题,MAIA能识别并移除模型(如ResNet-18)中对虚假关联(如犬种与背景间的不正确关联)敏感的神经元,从而增强模型在面对数据分布偏移时的稳健性和准确性。

论文链接:https://arxiv.org/abs/2404.14394

相关新闻

-

2025-06-18

超算互联网入选工信部《算力强基揭榜行动》名单

-

2025-05-07

最佳实践Vol.38 | 基于RAGFlow+DeepSeek API,打造面向政务领域的AI智能助手

-

2025-05-06

论文解读Vol.5 | 字节跳动推出MD模拟预测框架BAMBOO,助力锂电池材料设计

-

2025-04-30

最佳实践Vol.37 | LAMMPS计算热导率与Python数据后处理实践详解

-

2025-04-29

0day适配国产算力!阿里Qwen3上线超算互联网,支持企业级部署

津公网安备12011602300273号

津公网安备12011602300273号

电子营业执照

电子营业执照

微信服务号

微信服务号