今日凌晨,OpenAI连发两款开源推理模型:gpt-oss-120b和gpt-oss-20b。这是自2019年GPT-2开源后,OpenAI首次回归推出开源大语言模型。该模型采用宽松的Apache2.0 协议开源,允许商用无需付费或授权。

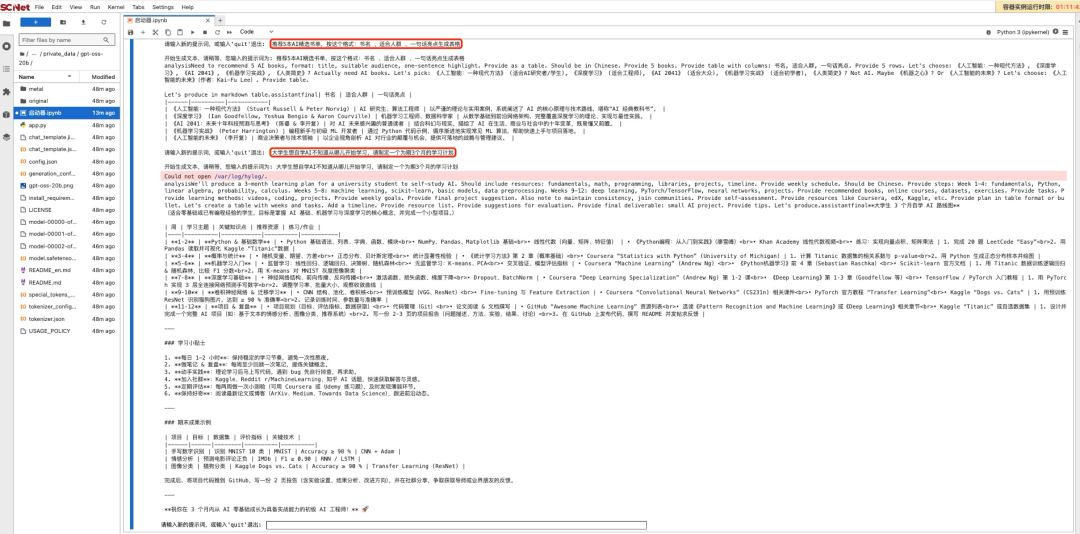

超算互联网已火速上线gpt-oss,企业和开发者可登录超算互联网AI社区,下载模型进行快速开发。除提供gpt-oss模型文件外,依托超算互联网平台的超智融合算力、安全可信的环境,平台支持gpt-oss-20b免费在线推理服务,实现云端开箱即用。

超算互联网AI社区支持gpt-oss模型快速开发-免费试用

一键开启对话,超算互联网提供gpt-oss在线推理服务

模型链接:

https://www.scnet.cn/ui/aihub/models/openaimodels/gpt-oss-20b

gpt-oss核心亮点如下:

宽松的Apache 2.0许可证:可自由用于构建,无copyleft限制或专利风险——是实验、定制和商业化部署的理想选择。

可配置的推理投入:可根据用户的具体用例和延迟需求,轻松调整推理投入(低、中、高)。

完整的思维链:可完整访问模型的推理过程,从而简化调试并提升输出结果的可信度。

支持微调:支持参数级微调,可根据您的特定用例对模型进行完全定制。

智能体能力:利用模型原生的函数调用、网页浏览、Python代码执行和结构化输出等能力。

原生MXFP4量化:在训练时,模型的混合专家(MoE)层便采用了原生的MXFP4精度,使得gpt-oss-120b在单张H100 GPU上即可运行,而gpt-oss-20b仅需16GB内存。

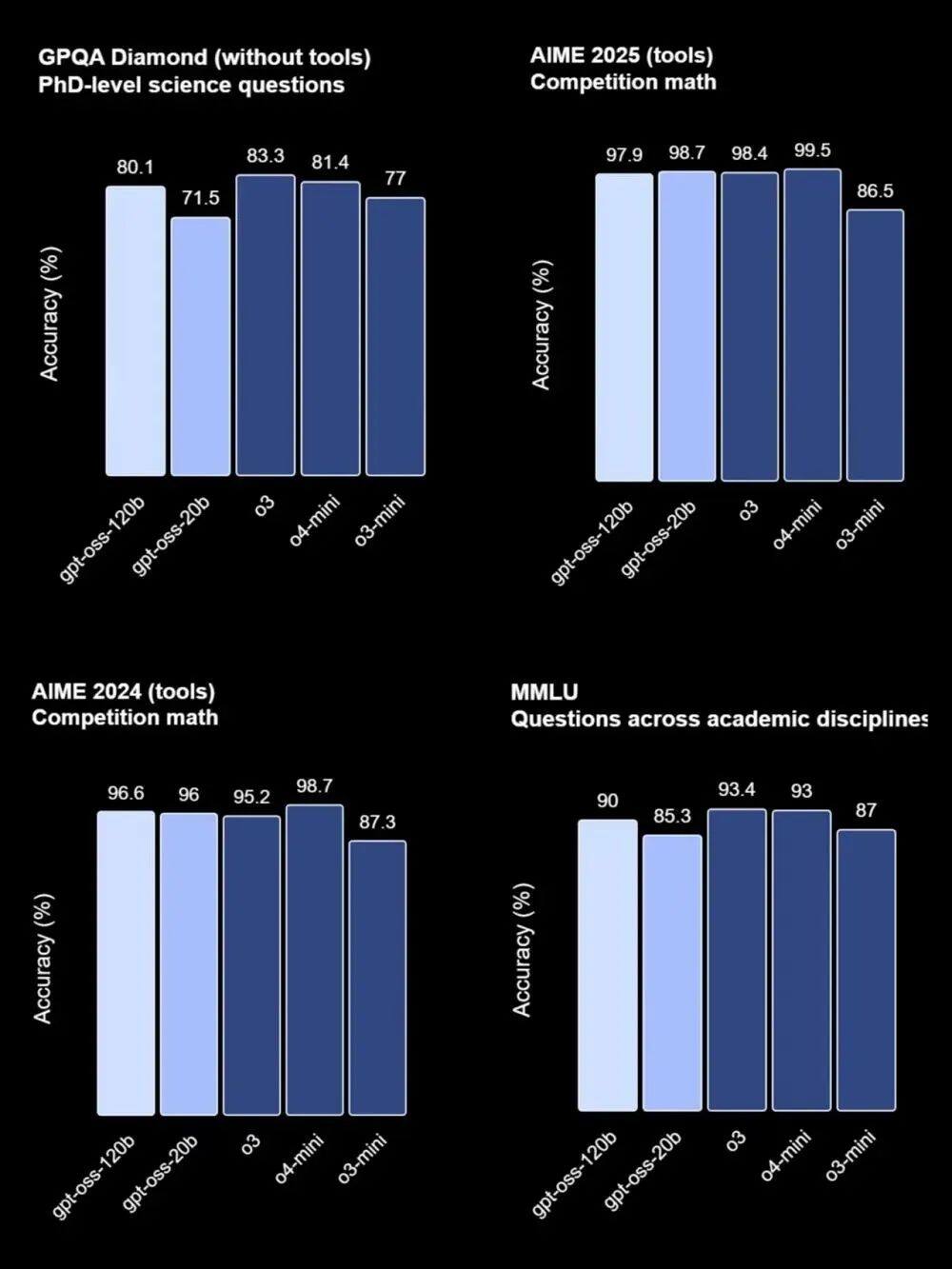

根据技术报告显示,在多项基准测试中,gpt-oss-120b的表现与OpenAI o4-mini几乎持平,包括编程竞赛(Codeforces)、通用问题解决(MMLU和HLE)、工具调用(TauBench)、健康相关查询(HealthBench)以及数学竞赛(AIME 2024 & 2025)。在部分测试中,其性能甚至优于旗舰模型GPT-4o。

gpt-oss-20b则与OpenAI o3-mini性能相当,在AIME和HealthBench等测试中表现更佳。工具使用、小样本函数调用也是其强项之一。

面向Agent场景,这两款模型已经与OpenAI的Responses API兼容,可用于Agent工作流,具备较好的指令遵循能力、网页搜索或Python代码执行等工具使用能力以及推理能力,还支持调整模型推理长度。

此外,值得一提的是,StabilityAI创始人Emad Mostaque等人,对gpt-oss与DeepSeek进行了对比:

训练效率:gpt-oss-120b每个token激活约5.1B参数,而DeepSeek 是 37B,少了 7 倍以上,因此可以处理超过5倍的tokens,即大约80万亿 tokens(作为参考,Qwen3使用了30万亿)。

计算消耗:gpt-oss比DeepSeek V3/R1的训练算力需求低了约20%,即使如此,仍能训练更多tokens(最多 80T vs DeepSeek 的 14.8T)。

训练成本:gpt-oss-120b约400万美元,gpt-oss-20b仅需 40 万美元,均低于DeepSeek 。

可以看到,gpt-oss模型以更低的激活参数量、更少的算力消耗和显著优化的训练成本,实现了更高的性价比优势。

作为国家级算力服务平台,截至今年7月,超算互联网用户数已超40万,API调用规模日均超百万次,AI社区上线热门开源大模型270多款。基于国产深算智能加速卡的良好生态,平台第一时间上线DeepSeek-R1、QwQ-32B、GLM等国产开源模型,并构建集在线推理、模型开发、私有化部署等功能于一体的MaaS服务。

相关新闻

-

2025-08-11

双剑合璧,AI提效神器1+1 | 在超算互联网体验全新CodeBot系列产品

-

2025-08-11

超算&AI应用周报Vol.68 |Qwen-Image免费在线文生图,gpt-oss一键开启对话

-

2025-08-08

“商业+技术”双突破!看超算互联网打造生态孵化新范式

-

2025-08-08

免费在线试玩!当职场人遇上Qwen-Image,人人都是设计师

-

2025-08-04

“聚焦材料创新与数据智能” 国家超算互联网生态沙龙邀您再聚郑州!

津公网安备12011602300273号

津公网安备12011602300273号

电子营业执照

电子营业执照

微信服务号

微信服务号